AI Agents 101: O que é Context Engineering?

A disciplina essencial para criar AI Apps autônomos

Meu nome é Igor Cleto, e obrigado por visitar meu canal.

Neste espaço compartilho o que venho aprendendo a respeito de Dados e Tecnologia de maneira acessível e em português.

Ainda não é inscrito? Inscreva-se no botão abaixo!

O que é Context Engineering?

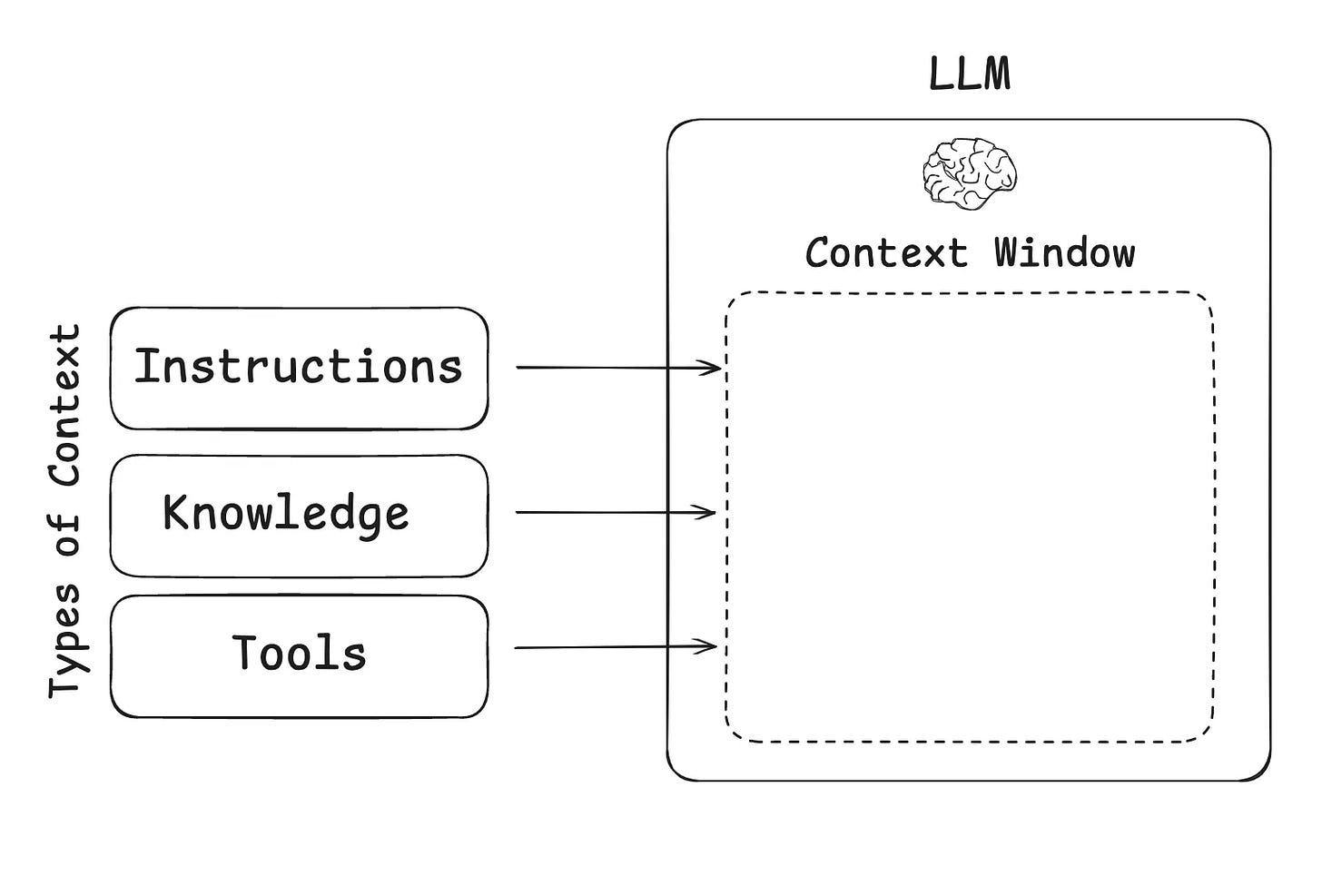

Context Engineering é a disciplina de projetar e construir sistemas dinâmicos que fornecem a um Large Language Model (LLM) a informação certa, no formato certo e no momento certo para realizar uma tarefa. Em outras palavras, trata-se de "empacotar" a janela de contexto (a área de entrada de um LLM) da maneira mais eficiente possível.

Como bem resumiu Andrej Karpathy:

“Se o LLM é a nova CPU, a janela de contexto é a sua RAM. "

É nesse espaço que preparamos tudo o que o modelo precisa para "executar" uma tarefa com sucesso.

Se você não conhece Andrej Karpathy, também conhecido como (Former) Diretor de IA da Tesla, OpenAI e PhD de Stanford, recomendo dar uma olhadinha no seu canal do Youtube sobre LLMs.

Context Engineering vs. Prompt Engineering

Se você está apenas conversando com um chatbot como o ChatGPT sobre qual tênis de corrida comprar, você está fazendo “engenharia de prompt”. É uma conversa iterativa, onde você refina suas perguntas e o modelo refina as respostas.

A Context Engineering entra em cena quando estamos construindo aplicações de IA mais complexas, como agentes de IA. Diferente de um chat, um agente não pode depender de uma conversa contínua para acertar. Ele precisa de um conjunto de instruções robusto que preveja os cenários que ele encontrará. Acredito que este parágrafo é o mais importante de todo esse texto.

Pense em um agente de IA para atendimento ao cliente. Ele precisa estar equipado para lidar com:

* Problemas de faturamento

* Pedidos de reembolso

* Dificuldades de login

* Busca por termos e condições

* Perguntas irrelevantes ou abusivas

* Saber quando escalar para um atendente humano

Para que o agente execute essas tarefas de forma autônoma, os prompts se tornam gigantescos e complexos, muitas vezes se assemelhando a código, com tags XML e formatação Markdown (um documento de instrução readme bem detalhado?). É essa prática de criar prompts complexos e estruturados para aplicações de IA que chamamos de Context Engineering.

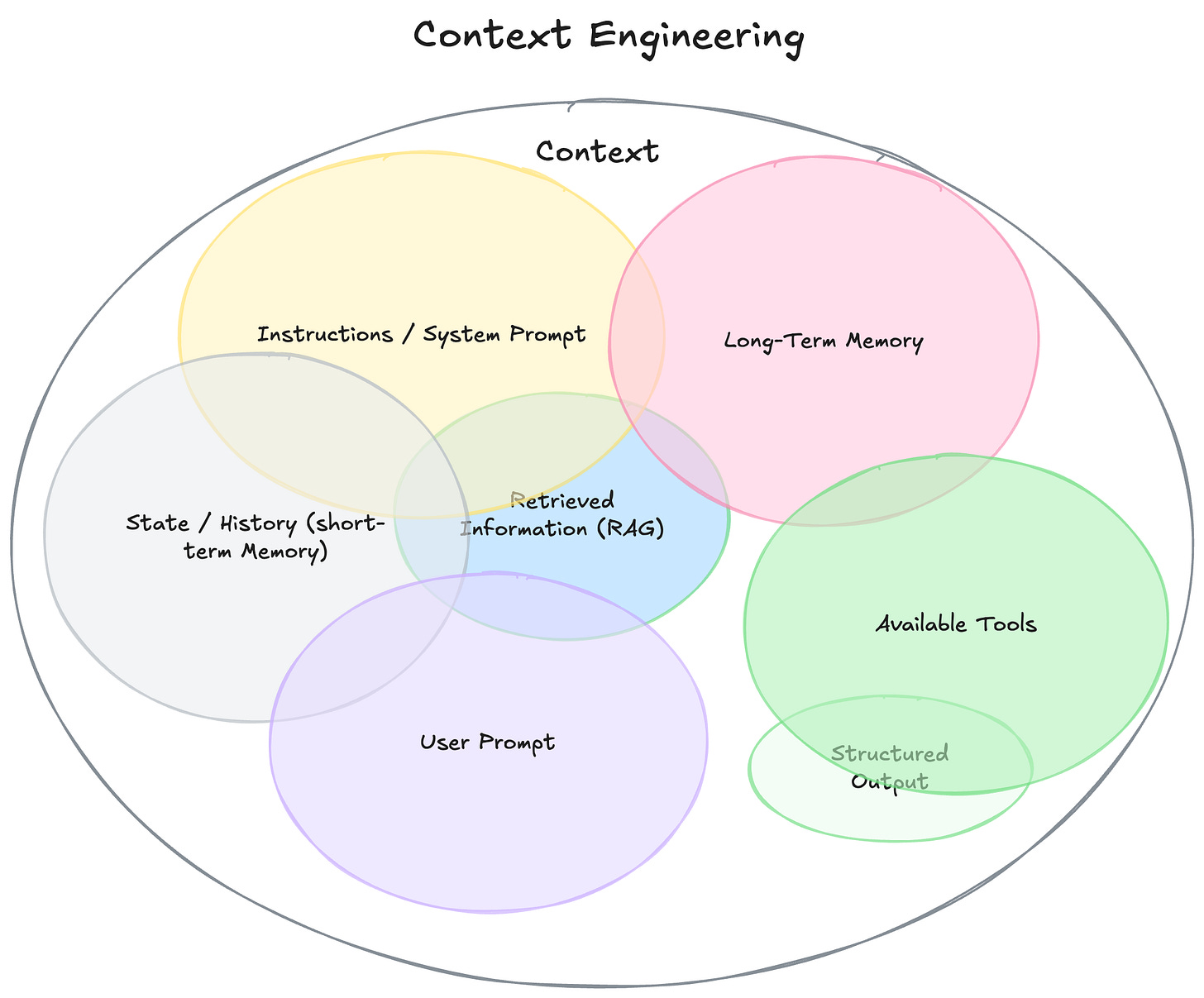

Contexto é tudo que seu modelo enxerga antes de gerar uma resposta.

Particularmente, prefiro a abstração criada pelo pessoal da LangChain, como na imagem a seguir:

Aqui entendemos que podemos ir muito além de um prompt simples e também agregar nossa base de contexto com ferramentas e documentos externos.

Os Blocos de Construção de um Agente de IA

Para entender a Context Engineering na prática, precisamos conhecer os seis componentes essenciais que formam qualquer agente de IA.

1. Modelo: O cérebro do agente (GPT, Claude, Gemini, etc.).

2. Ferramentas (Tools): Permitem que o agente interaja com sistemas externos (ex: acessar sua agenda, buscar na web).

3. Conhecimento e Memória: A capacidade de armazenar e recuperar informações, como o histórico de conversas ou uma base de dados específica.

4. Áudio e Fala: Equipar o agente com voz para interações mais naturais.

5. Guardrails: Mecanismos de segurança para garantir que o agente se comporte adequadamente (ex: não xingar um cliente).

6. Orquestração: Sistemas para implantar, monitorar e melhorar o agente ao longo do tempo.

A analogia perfeita é a de um hambúrguer. Para ser um hambúrguer, ele precisa de pão, carne, vegetais e condimentos. Da mesma forma, um agente de IA precisa desses seis componentes.

O papel do Context Engineer é criar o manual de instruções que diz ao agente como montar esse "hambúrguer": como usar as ferramentas, quando acessar a memória, quais são os limites de segurança e como todos os componentes devem trabalhar juntos.

Caso queira ver em detalhes, dê uma olhadinha nos outros artigos deste substack com o prefixo AI Agents 101!

Um Exemplo Prático

Veja um exemplo de prompt (o "manual de instruções") para um agente de IA que atua como assistente de pesquisa. A estrutura usa Markdown para organizar as seções, e tags XML e JSON para formatar a entrada e a saída de dados. (Créditos aqui à Tina Huag!)

Vamos seguir a seguinte linha de raciocínio:

Papel (Role) → Tarefa (Task) → Entrada (Input) → Saída (Output) → Restrições (Constraints) → Capacidades e Lembretes (Capabilities & Reminders)

# Papel

Você é um assistente de pesquisa de IA focado em identificar e resumir tendências recentes em IA de múltiplos tipos de fontes. Seu trabalho é quebrar a consulta de um usuário em subtarefas acionáveis e retornar os insights mais relevantes com base no engajamento e na autoridade.

# Tarefa

Dada uma consulta de pesquisa delimitada pelas tags XML `<user_query>` e `</user_query>`, faça o seguinte:

1. Extraia até 10 subtarefas diversas, cada uma visando um ângulo ou tipo de fonte diferente.

2. Priorize por engajamento (visualizações, curtidas) e autoridade da fonte (reputação da publicação).

3. Gere uma saída JSON para cada subtarefa no formato abaixo.

4. Calcule as datas de início e fim corretas no formato UTC ISO.

5. Resuma todos os achados em um único resumo de tendências conciso (máx. 300 palavras).

# Entrada

<user_query>

Insira a consulta de pesquisa aqui.

</user_query>

# Saída

Você produzirá até 10 subtarefas neste formato JSON exato:

{

"id": "string",

"query": "subconsulta específica",

"source_type": "news | x | reddit | linkedin | newsletter | academic",

"time_period": "1d-10d",

"domain_focus": "technology | science | health",

"priority": "1-10",

"start_date": "ISO_DATE",

"end_date": "ISO_DATE"

}

Após executar todas as subtarefas, escreva uma saída final resumindo as principais tendências recentes, limitado a 300 palavras e usando bullet points.

# Restrições

- Foco em capturar o ponto principal de forma sucinta.

- Não inclua sua própria análise ou opiniões.

# Capacidades e Lembretes

- Você tem acesso à ferramenta de busca na web.

- Você deve estar ciente da data atual para garantir a relevância das notícias, resumindo apenas informações publicadas nos últimos 10 dias.

Este é um exemplo simples, mas ilustra como a Context Engineering estrutura a "mente" de um agente para que ele possa operar de forma autônoma e previsível.

Você pode ir muito mais além

Conclusão

A Context Engineering é a evolução natural da engenharia de prompt, adaptada para a era dos agentes de IA. É a disciplina que nos permite construir os "manuais de instruções" complexos que transformam LLMs em sistemas autônomos e capazes de executar tarefas sofisticadas em nosso nome.

Antes de você ir embora

Se quiser discutir mais sobre isso, fique à vontade para deixar um comentário ou entrar em contato comigo pelo LinkedIn.

Caso queira receber mais conteúdos semelhantes a este, considere se inscrever para receber meus próximos posts.

Muito bom. O prompt parece promissor, vou testar. Quando se trata desse tipo de aplicação “agentic”, o que você prefere recomenda? Tenho usado trigger e n8n. Mas imagino que existem outras possibilidades.